Het I&P blog is vanaf nu te vinden op http://blogs.library.leiden.edu/ublinnovatie/ .

Studiemiddag Wiki-wetenschappers

Dit keer een gast-blog van Christiaan van Arkel, die tot 1 januari in dienst is van I&P om te helpen met allerlei verbeteringen rondom Islandora. Zijn afstudeerscriptie schreef hij over het gebruik van Linked Open Data door universiteitsbibliotheken. Hij bezocht op 26 september een studiemiddag van de Stichting Academisch Erfgoed rondom de impact van Wiki-projecten en schreef hierover onderstaand verslag.

Het eerste deel van de middag had betrekking op het specifieke project Wiki Wetenschappers. Projectleider Linn Borghuis vertelde over dit project. SAE is dit project begonnen om informatie over hoogleraren te centraliseren. In een bredere context gaat dit bijvoorbeeld ook over hoogleraar archieven, maar in eerste instantie focust het project zich op biografische data van overleden hoogleraren. Deze informatie is momenteel beschikbaar in allerlei boeken en op verschillende websites, universiteits- en privé archieven, waaronder Leidse Hoogleraren vanaf 1575. Deze verspintering van informatie resulteerde in een zoektocht naar een centraal punt met alle informatie over hoogleraren. Hiervoor wilde ze geen nieuw portaal ontwikkelen. De oplossing bleek Wikidata.

Het eerste deel van de middag had betrekking op het specifieke project Wiki Wetenschappers. Projectleider Linn Borghuis vertelde over dit project. SAE is dit project begonnen om informatie over hoogleraren te centraliseren. In een bredere context gaat dit bijvoorbeeld ook over hoogleraar archieven, maar in eerste instantie focust het project zich op biografische data van overleden hoogleraren. Deze informatie is momenteel beschikbaar in allerlei boeken en op verschillende websites, universiteits- en privé archieven, waaronder Leidse Hoogleraren vanaf 1575. Deze verspintering van informatie resulteerde in een zoektocht naar een centraal punt met alle informatie over hoogleraren. Hiervoor wilde ze geen nieuw portaal ontwikkelen. De oplossing bleek Wikidata.

De doelen van het project waren:

- Het ontsluiten van biografische data over hoogleraren in een centrale database, Wikidata dus.

- Een compleet historisch overzicht creëren van alle Nederlandse hoogleraren.

- Kennis vergaren over het werken met Wikimedia projecten.

- Kennis vergaren over privacy en de AVG in relatie tot bovenstaande doelen.

De resultaten die behaald zijn:

- Een compleet historisch overzicht van de biografische gegevens van hoogleraren.

- Alle instellingen (universiteiten) deden mee.

- Kennis over privacy en de AVG verkregen over hoe om te gaan met gegevens over levende hoogleraren.

Aandachtspunten tijdens het proces:

- Er komt veel maatwerk kijken bij het importeren van de data in Wikidata.

- Data-normalisatie kost veel werk, denk daarbij aan standaardiseren van roepnamen en voorletters bijvoorbeeld.

- Het is een kracht dat alle universiteiten meedoen, maar tegelijkertijd is het contact onderhouden tussen die verschillende organisaties ook erg intensief.

- Tijdens het project kwamen ze tot de conclusie dat ze meer tijd hadden moeten nemen voor het hele project.

Het vervolg van het project:

- Ook levende hoogleraren opnemen.

- Verzamelde informatie terug laten vloeien naar de instellingen.

- De vraag beantwoorden van hoe de database up-to-date te houden.

Wikimedia in Residence (WIR) Hanno Lans vertelde over zijn ervaringen tijdens dit project. Tijdens het project kwam de vraag naar voren wat nou eigenlijk geschikte data was? Grappig genoeg bleken boeken een hele belangrijke en rijke bron te zijn. Het boek is dan meteen ook een complete en gearchiveerde dataset. Daarom ook de aanmoediging voor universiteiten om vooral lustrumboeken en dergelijke te blijven uitgeven. Daarnaast bleken ook universiteitswebsites en platforms zoals Album academicus van de UvA bruikbare datasets te zijn. Uiteraard waren er ook problemen, één daarvan was de verdeling van academische functies; het verschil tussen een hoogleraar en een bijzonder hoogleraar, wat een typisch Nederlands begrip is. Ze hebben nog niet echt een oplossing gevonden voor dit probleem in de internationale context van Wikidata.

De diversiteit in datasets zorgde voor dat er veel tijd nodig was om die data op te schonen en bruikbaar te maken. Daarnaast was er ook een probleem in het opzetten van functies en faculteiten, met name door de historiciteit van de instellingen, waardoor faculteitsnamen en functies veranderen door de geschiedenis. Door bovenstaande problemen was er dus ook veel tijd nodig voor nabewerking en daardoor is er een verkeerde tijdsinschatting gemaakt.

Als derde sprak Marianne Loef over privacy en de AVG. Daarbij ging het over het vraagstuk in hoeverre de AVG van toepassing is op het project Wiki Wetenschappers. De AVG gaat om persoonsgegevens en over bijzondere persoonsgegevens. Bijzondere persoonsgegevens zijn bijvoorbeeld godsdienst, politieke overtuiging, gezondheid, ras, lidmaatschap vakbond, seksualiteit, genetische en biometrische data. Wat persoonsgegevens en bijzondere persoonsgegevens zijn is ook afhankelijk van de context. Als ik bijvoorbeeld een kenteken zie van een auto dan kan ik dat kenteken niet herleiden tot een persoon, daardoor is het op dat moment geen persoonsgegeven, maar voor de politie is het kenteken wel een persoonsgegeven omdat die toegang heeft tot een systeem waarin hij of zij het kenteken met een persoon kan koppelen.

Het verwerken van persoonsgegevens is ook belangrijk, niet alleen het verzamelen en beheren van persoonsgegevens is het verwerken maar ook het op een goede manier vernietigen van persoonsgegevens is het verwerken. Het is altijd belangrijk om mogelijke schade in overweging nemen als je persoonsgegevens gaat verwerken:

- Exploitatie

- Identiteitsfraude

- Criminelen

- Discriminatie

- Uitsluiting

- Framing

- Manipulatie

- Beperking keuzevrijheid

- Verlies morele autonomie (bijv. China)

- Stigmatisering, imagoschade

Denk daarbij vooral ook aan dat persoonsgegevens worden gebruikt voor handel. Cambridge Analytica als bekendste voorbeeld. Als je persoonsgegevens gaat verwerken is het belangrijk om passende beveiligingsmaatregelen te nemen. Eén daarvan is een PIA (Privacy Impact Assessment) maken.

In het kader van dit project is het belangrijk om te weten op welke grond je persoonsgegevens mag verwerken. De grond die van toepassing is op dit project is historie en wetenschap, daarnaast geldt de AVG niet voor overleden personen, tenzij een persoonsgegeven herleidbaar is naar een levend persoon (een erfelijke ziekte bijvoorbeeld). Hoogleraren zijn publiek domein: hun oratie en ambtsaanvaarding zijn openbaar. Hierbij heb je dus het verschil tussen openbare en ‘gewone’ personen. Mogen universiteiten persoonsgegevens van hoogleraren online zetten? Ja, dat mag, het hoogleraarschap is een openbaar ambt. Natuurlijk zijn er ook risico’s zoals profilering en een geboortedatum die misbruikt kan worden om bijvoorbeeld medische gegevens op te vragen. Om hier goed mee om te gaan is te zorgen voor een goede klachtenafhandeling en door een privacyverklaring online te zetten.

Olaf Janssen Wikimedia coördinator voor de KB sprak over de beelddonaties die de KB heeft gedaan op Wikimedia Commons en de vraag of dat een enkele reis is of dat je er als culturele instelling nog iets voor terug krijgt. Het doel van de Wikimedia coördinator is de wereld van de KB en de Wikiwereld samenbrengen. Helaas is er nog geen sprake van een cyclus bij de KB. De twee werelden bestaan nog erg los van elkaar. De Wikimedia projecten en de kernsystemen van de KB werken nog niet samen. Er bestaan heel veel meer mogelijkheden, maar die worden niet goed benut.

Waarom is dat zo moeilijk?

- Technische barrières

- Tekort aan middelen

- Tekort aan kennis

- Tekort aan vertrouwen

- Er is een wantrouwen in de kwaliteit van Wikimedia projecten.

Het beleidsplan van de KB spreekt over het werken met woorden, daarbij wordt de focus dus gelegd op het geschreven woord. Er wordt dus bijna vergeten dat de KB hele mooie beeldcollecties heeft. Deze collecties bestaan onder andere uit:

- Middeleeuwse handschriften

- Atlassen

- Wapenboeken

- Grafiek

- Boekbanden

- Centsprenten

Deze beeldcollecties bestaan versnipperd door de KB. De KB heeft dan ook geen eigen beeldplatform. Het hebben van een eigen beeldplatform zorgt voor een beperkt bereik. Daarom maken ze gebruik van Wikimedia Commons. De KB heeft rechten vrije beelden geplaatst op Wikimedia Commons. De beelddonaties die gedaan worden moeten wel aan een aantal voorwaarden voldoen; het moeten afbeeldingen zijn die zich in het publieke domein bevinden, ze moeten relevant zijn voor Wikipedia, visueel aantrekkelijk zijn en een goede resolutie hebben.

Olaf constateerde 4 gevolgen van beelddonaties. De eerste is betere zichtbaarheid. Als voorbeeld gaf hij het boek Nederlandse Vogelen van Nozeman en Sepp. In 2014 is de gedigitaliseerde versie van dit boek als topstuk in hoge resolutie op KB.nl gezet. Deze versie is in 2016 34.710 keer bekeken in op KB.nl. In 2015 zijn alle 264 scans van het boek op Wikimedia Commons gezet. 66 van deze 264 zijn gebruikt in 213 Wikipedia artikelen in 52 talen. De scans van het boek zijn in 2016 op Wiki Commons 3.725.876 keer bekeken.

Het tweede gevolg van beelddonatie is het commercieel hergebruik van afbeeldingen in het publieke domein. Dat is toegestaan. Olaf noemde twee voorbeelden waarin het hergebruik een beetje was doorgeslagen. Ten eerste de stockphoto site Alamy die een beeld uit het Visboek van Coenen aanbood voor €17680,00. Het tweede voorbeeld was een dekbedden fabrikant die het beeld gebruikte als bedrukking voor een dekbed.

Het derde gevolg van beelddonatie is externe expertise uit onverwachte hoek. Het Fécamp psalter werd door de KB op Wikimedia Commons geplaatst. Een dag later verscheen er op Wikipedia een artikel over dit boek. Dit bleek gedaan door ene Jean-Pierre Remy. De KB heeft contact met deze man gezocht en gevraagd welke boeken hij graag zou willen beschrijven in een Wikipedia artikel. Door deze kleine samenwerking zijn een aantal items uit de KB collectie op een hele goede manier beschreven in Wikipedia.

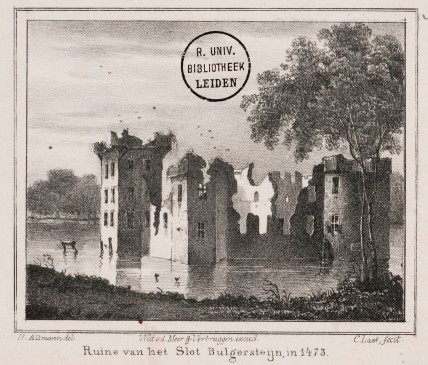

Het vierde gevolg van beelddonatie is de mogelijkheid tot nieuwe manieren van zoeken en vinden. Het voorbeeld hierbij is de Atlas De Wit. Afbeeldingen van die atlas waar Leiden op afgebeeld staat zijn op KB.nl alleen te vinden via de index. Door de afbeeldingen op Wikimedia Commons te plaatsen met de plaatsnamen in de titel is het mogelijk om te zoeken op plaatsnaam. Naast deze manier van zoeken biedt Wikimedia Commons sinds kort de mogelijkheid om gestructureerde data toe te voegen aan media items. Met de eigenschap ‘beeldt af’ (P180) is mogelijk om aan te geven wat er op de afbeeldingen te zien is. Zo wordt het bijvoorbeeld mogelijk om te zoeken naar alle steden aan de Zuiderzee of naar afbeeldingen te zoeken waar 1 hond en 2 pauwen op staan afgebeeld. Terwijl dit informatie is die niet specifiek in de metadata is vermeld. Dit biedt natuurlijk prachtige mogelijkheden om de collectie Topografische Prenten van de UBL voor een groter publiek beschikbaar te stellen. Een handige tool hiervoor is ISA (https://tools.wmflabs.org/isa/). Hierin kan je een campagne aanmaken en het publiek laten identificeren wat er op de afbeeldingen te zien is.

Het vierde gevolg van beelddonatie is de mogelijkheid tot nieuwe manieren van zoeken en vinden. Het voorbeeld hierbij is de Atlas De Wit. Afbeeldingen van die atlas waar Leiden op afgebeeld staat zijn op KB.nl alleen te vinden via de index. Door de afbeeldingen op Wikimedia Commons te plaatsen met de plaatsnamen in de titel is het mogelijk om te zoeken op plaatsnaam. Naast deze manier van zoeken biedt Wikimedia Commons sinds kort de mogelijkheid om gestructureerde data toe te voegen aan media items. Met de eigenschap ‘beeldt af’ (P180) is mogelijk om aan te geven wat er op de afbeeldingen te zien is. Zo wordt het bijvoorbeeld mogelijk om te zoeken naar alle steden aan de Zuiderzee of naar afbeeldingen te zoeken waar 1 hond en 2 pauwen op staan afgebeeld. Terwijl dit informatie is die niet specifiek in de metadata is vermeld. Dit biedt natuurlijk prachtige mogelijkheden om de collectie Topografische Prenten van de UBL voor een groter publiek beschikbaar te stellen. Een handige tool hiervoor is ISA (https://tools.wmflabs.org/isa/). Hierin kan je een campagne aanmaken en het publiek laten identificeren wat er op de afbeeldingen te zien is.

Christiaan

Link naar presentatie Olaf Janssen: https://www.slideshare.net/OlafJanssenNL/beelddonaties-enkele-reis-of-retour-studiemiddag-wiki-wetenschappers-sae-26-september-2019-utrecht

Projectpagina Wiki Wetenschappers: https://www.wikidata.org/wiki/Wikidata:Wiki-wetenschappers

De advertentiebibliotheek

Verschenen in IP 2019/5

JOMO

Hoera, er zoemt weer een nieuw acroniem door de blogs! JOMO lijkt op FOMO en heeft er ook alles mee te maken. FOMO is de Fear Of Missing Out. Iedereen kent ze wel, de verslaafden die de hele dag, en bij voorkeur een groot deel van de nacht, aan hun device vastgekleefd zitten om maar niets te hoeven missen van wat er op Facebook, Instagram of Twitter voorbijschuift. En misschien heb je zelf wel FOMO. Voor jou is er nu JOMO, de Joy Of Missing Out. Kort gezegd gaat het erom dat je je tablet of smartphone regelmatig weglegt om met het echte leven bezig te zijn. JOMO is eigenlijk wat je ouders of partner al jaren tegen je zeggen. Voorheen was dat tegen dovemansoren, maar nu is dat voorbij, want JOMO is een heuse trend. De afgelopen periode werd erover geschreven door de Frankfurter Allgemeine, Victoria Health, Women’s Health Magazine en Search Engine Journal, om er maar een paar te noemen. En natuurlijk worden de artikelen gelardeerd met de bekende 5 of 10 tips, zoals:

Hoera, er zoemt weer een nieuw acroniem door de blogs! JOMO lijkt op FOMO en heeft er ook alles mee te maken. FOMO is de Fear Of Missing Out. Iedereen kent ze wel, de verslaafden die de hele dag, en bij voorkeur een groot deel van de nacht, aan hun device vastgekleefd zitten om maar niets te hoeven missen van wat er op Facebook, Instagram of Twitter voorbijschuift. En misschien heb je zelf wel FOMO. Voor jou is er nu JOMO, de Joy Of Missing Out. Kort gezegd gaat het erom dat je je tablet of smartphone regelmatig weglegt om met het echte leven bezig te zijn. JOMO is eigenlijk wat je ouders of partner al jaren tegen je zeggen. Voorheen was dat tegen dovemansoren, maar nu is dat voorbij, want JOMO is een heuse trend. De afgelopen periode werd erover geschreven door de Frankfurter Allgemeine, Victoria Health, Women’s Health Magazine en Search Engine Journal, om er maar een paar te noemen. En natuurlijk worden de artikelen gelardeerd met de bekende 5 of 10 tips, zoals:

- Zeg nee tegen pushberichten!

- Lees geen emails na acht uur ’s avonds!

- Ga naar een echte boekwinkel en koop een echt boek!

- Leef langzaam!

Het begrip JOMO werd zeven jaar geleden geïntroduceerd in een blog van de Amerikaan Anil Dash, waarin hij beschrijft hoe weldadig het is om sociale gelegenheden te laten lopen. In de jaren die volgden verschenen er veel en artikeltjes en blogs over JOMO waarbij er vooral werd gefocust op verslaving aan sociale media. Onthaasting was het antwoord, want JOMO voelt zich thuis in de wereld van Mindfulness en Marie Kondo.

Dus doe mee met JOMO! Koop de JOMO-koffiemok of het JOMO-boek (Ja, ze zijn er. Vorige maand verscheen zelfs een JOMO breiboek)! Hang in je pyjama voor de buis met een zak borrelnootjes! Wees jong! Wees JOMO!

Deze tekst verscheen als column in IP – vakblad voor informatieprofessionals -2019/4

De getemde (deep)fakes

Klik hier om de (prettiger leesbare) pdf-versie op te halen.

De opmars van het geluidje

Verschenen in IP 2019/2

Technochauvinisme

Symposium Rediscovered: new technologies on historical artefacts

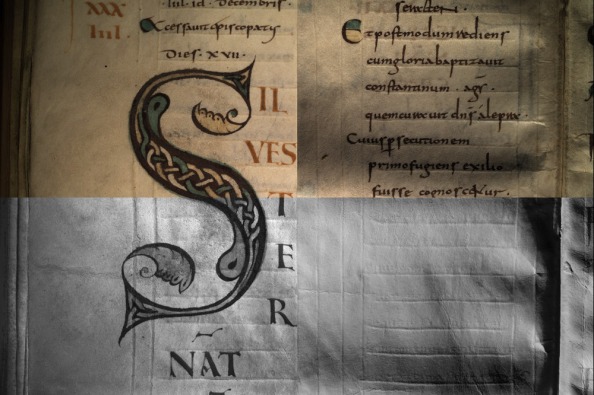

Liber Pontificalis. UBL VLQ 60, fol. 20r. Images made with various filters of the White Light Portable Light Dome, developed by KU Leuven.

The materiality of historical artefacts and the development of new digital technologies might seem to contradict, however, quite the opposite is true. Increasingly digital technology is deployed to deepen our knowledge of cultural heritage in the broadest sense. On November 16. 2018 Leiden University Libraries invited a variety of speakers to discuss the rediscovery of historical artefacts through new technology, by focusing not only on the technology itself but also on the implications for historical research and our understanding of our material heritage.

The symposium is part of the program Beyond content, with which the UBL focuses on the materiality of text and images through a series of activities like workshops, presentations and an exhibition. Specific attention is paid to the forms in which historical texts and images have been handed down, but also to the digital techniques that have recently been developed to better study them. For more information on the programme see the website Beyond content.

The speakers introduced us to a range of methods, tools and algorithms often borrowed from the beta sciences and applied within the humanities. That these do not always need to be high end and expensive, was shown by the first keynote speaker Kate Rudy (University of St Andrews/NIAS). In her presentation Four technologies to spy on the past, she talked about the projects she will start as part of her upcoming Leverhulme Fellowship. As a medieval art historian she is interested in the production and use of illuminated manuscripts. In an earlier project she studied the use of texts and miniatures in a manuscript by measuring the grime with a densitometer. The calliper she will use to measure parchment thickness costs only 100 EUR, but serves perfectly find out whether leaves or quires were added to a manuscript.

Rudy also stressed the importance of handheld amateur photography. When libraries digitise a manuscript, they often focus on lavishly decorated and untouched manuscripts. But many researchers like her are particularly interested in the ugly, worn and broken ones. And cleaning a manuscript as part of a conservation project will lead to loss of information on the use of a manuscript as well. When researchers visit our library, they take many pictures from unstudied and non-digitised manuscripts or from surprising angles. These pictures are sometimes shared on Twitter, but most of the time they are only kept on standalone computers, unavailable to others. Although a lot of researchers do use free cloud storage like Google Photos and Flickr, this is not a reliable solution; the platforms can change the terms and conditions (Flickr recently limited the possibilities for free accounts), and sometimes simply shut down (just think of Picasa). This led to an interesting public discussion: do research institutions have a responsibility to store and share the results of DIY digitization? As a service it turned out to be very much desired by researchers.

Hannah Busch (Huygens ING) participated in the eCodicology project, in which several tools were developed to analyse large amounts of data taken from medieval manuscripts. In her presentation Machines and Manuscripts: New technologies for the exploration of medieval libraries she explained the use of algorithms for the automatic identification of lay-out elements, like columns, initials and miniatures. These data are added to the information taken from the descriptions in traditional catalogues. When combined they form a rich source for data visualisations of libraries as a whole. This makes it possible to gain better insight in book historical aspects like the relationship between format and size, or the percentage of manuscripts with decorations or miniatures.

In her new project at Huygens KNAW called Digital forensics for historical documents. Cracking cold cases with new technology the goal is to build a tool for script analysis in manuscripts based on convolutional neural networks. This technique is also used in image- and face technology.[1]

Meanwhile Hannah Busch offered a very useful summary of the needs of researchers as well. What she wants is to:

- Perform your own ingest with IIIF

- Run different types of analysis

- Share data

- Search/export/visualize

- Allow other people to annotate and correct

A prerequisite for this is of course to have the data FAIR: findable, accessible, interoperable and reusable.

Francien Bossema (Centrum Wiskunde en Informatica/Rijksmuseum/UvA) demonstrated the FlexRay Lab, a method for 3D visualisation using XRays and CT.[2] The non-invasive method can be used for medical imaging and food industry, but also for art historical research.

With the CT scanner it is possible to look inside objects in 3D during the scanning process. Together with the Rijksmuseum a workflow was developed that can be used both for both research during a conservation process and to reconstruct a production process. Bossema explained the method by reconstructing the production of a so-called Chinese puzzle ball. These decorative balls were made in the mid-18th ct from one single piece of ivory, consisting of several concentric spheres each of which rotates freely. Using the CT scanner it became clear that the spheres were made with a set of “L” shaped tools with progressively lengthening cutters. Only the outermost balls were carved elaborately.[3] Currently, they are working on an in-house scanner for the Rijksmuseum, to make the transition from 2D to 3D scanning possible by providing a standardised process for art historical research. As a result of these activities the Rijksmuseum is collecting large amounts of data. The museum is thus entering a new field and cooperation with institutions with more experience in this field, such as research institutes and libraries, is necessary.

The last years libraries and archives are increasingly confronted with growing collections of born digital scholarly archives. Peter Verhaar is working both for the Centre for Digital Scholarship of Leiden University Libraries and for the master’s programme in Book and Digital Media Studies. In his presentation Durable Access to Book Historical Data he discussed the challenges he was faced with in the acquisition of the digital archive of Professor Paul Hoftijzer. Hoftijzer, who is working on the Leiden book trade in the early modern period, has produced a rich collection of Word documents and Excel spreadsheets that he wanted to donate to the library. As a first step, Verhaar cleaned the unstructured data and transposed them to a database in systematic format. This essentially resulted in a new archive. The question for the audience was whether both of the archives should be kept. Cleaning up the “data grime” will in either case lead to a loss of information, in the same way as cleaning a physical manuscript does.

The pilot is also set up to raise awareness among researchers. The university library offers courses in data management to ensure that researchers know how to make their data FAIR. But we are now in the middle of a transition, researchers who are retiring the next couple of years never received these instructions, and in case no measures are taken, this will lead to loss of research data. Paul Hoftijzer, who was also attending the symposium, stressed the importance of keeping both a personal and a professional archive. In his opinion, only the combination of both can ensure a correct interpretation of the data.

Martijn Storms (Leiden University Libraries) introduced the audience to the crowdsourcing project Maps in the crowd that is running for more than 3 years now and has been very successful. With the help of enthusiastic volunteers almost 10.000 maps have been georeferenced, which means that users can find and use maps in an intuitive, geographic way, by browsing on a map. The maps can also be used in geographical data systems, e.g. to facilitate landscape analysis. The project attracted a lot of press, providing a large audience of map enthusiasts the opportunity to connect with the library and the collections.

In the afternoon the audience was invited to participate in an introductory workshop to IIIF.  You can try it out yourself here: https://digitalscholarship.nl/workshop/

You can try it out yourself here: https://digitalscholarship.nl/workshop/

Additionally, a pop-up exhibition was set up showing a selection of materials from the collection.

The final keynote by Giles Bergel (University of Oxford) focused on the physical and material aspects of the digital. He started his paper called Beyond fixity: the printing press in the age of digital reproduction by telling the story of the Doves press, responsible for the famous Doves font. After the two partners Thomas James Cobden-Sanderson and Emery Walker got into a severe dispute about the rights on the matrices in 1913, Cobden-Sanderson threw all of them into the Thames river. Since 2013 the Doves Type has been revived digitally by the designer Robert Green. He managed to recover 150 pieces of the original type from the Thames, which helped him to reproduce the font, including the imperfections of the original matrices. This story shows that “digital”, although increasingly experienced as something immaterial or even imaginary, has a materiality in itself as well. This sense of materiality is essential for book historical research, even when this is performed with a laptop and a package of software.

Giles Bergel is part of the Visual Geometry Group in Oxford, where tools are developed for visual analysis in of image and video content in a variety of academic disciplines like Humanities, History and Zoology. He is also Digital Humanities Ambassador in the Seebibyte project. One of the open source products developed is VISE, an application that can be used to make a large collection of images searchable by using image regions as query. VIA is an image annotation tool that can be used to define regions in an image and create textual descriptions of them. The Traherne digital collator finally makes it easy to compare copies of the same text in order to identify variants between them. Thanks to this tool, researchers no longer have to follow the so-called “Wimbledon-method” to compare prints, which means that headaches are fortunately something from the past.

The presentations can be found here:

[1] For an introduction see: https://adeshpande3.github.io/A-Beginner%27s-Guide-To-Understanding-Convolutional-Neural-Networks/ or read this article by Dominique Stutzmann in which the same technology is applied: https://journal.digitalmedievalist.org/articles/10.16995/dm.61/

[2] For more information on the project: https://www.cwi.nl/research/groups/computational-imaging

[3] https://www.cwi.nl/events/cwi-scientific-meetings-1/cwiscientific.pdf With images and extensive description.